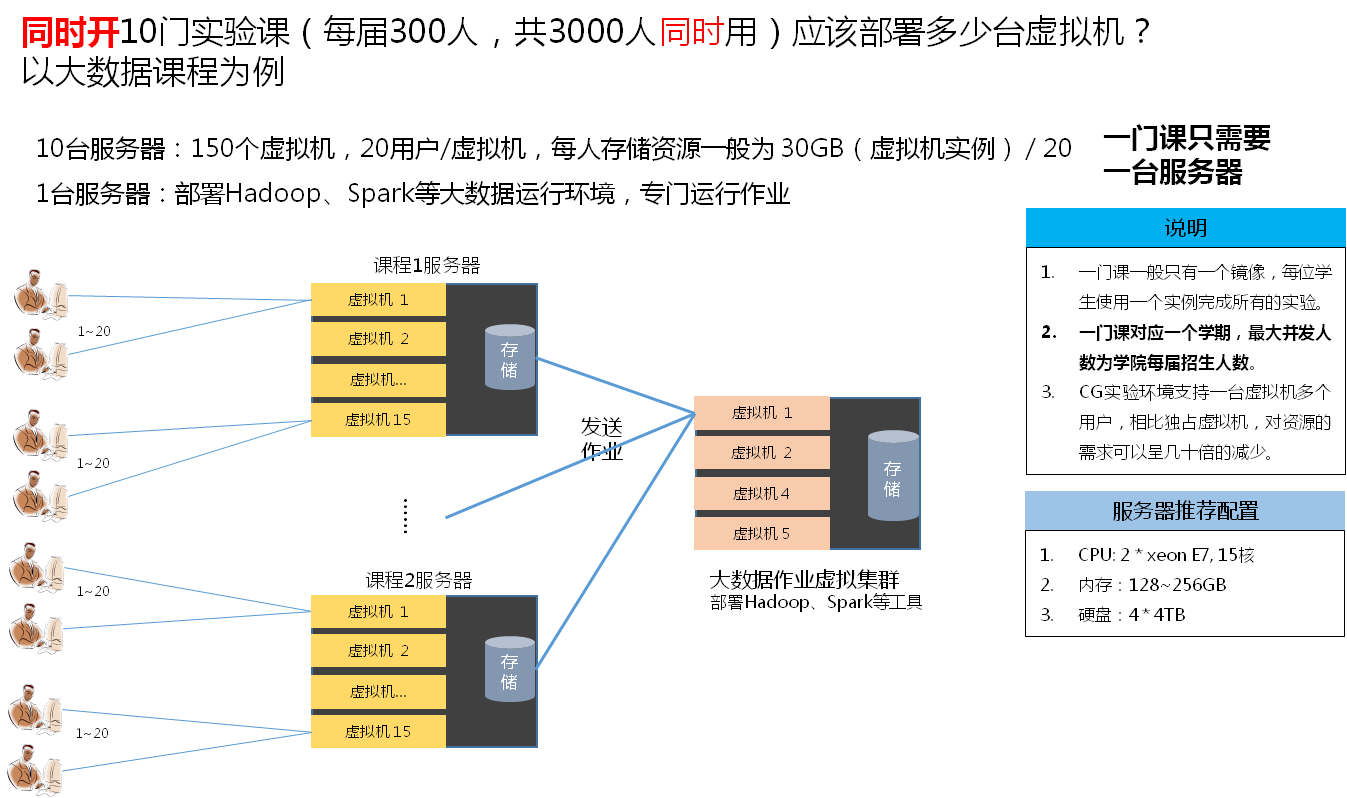

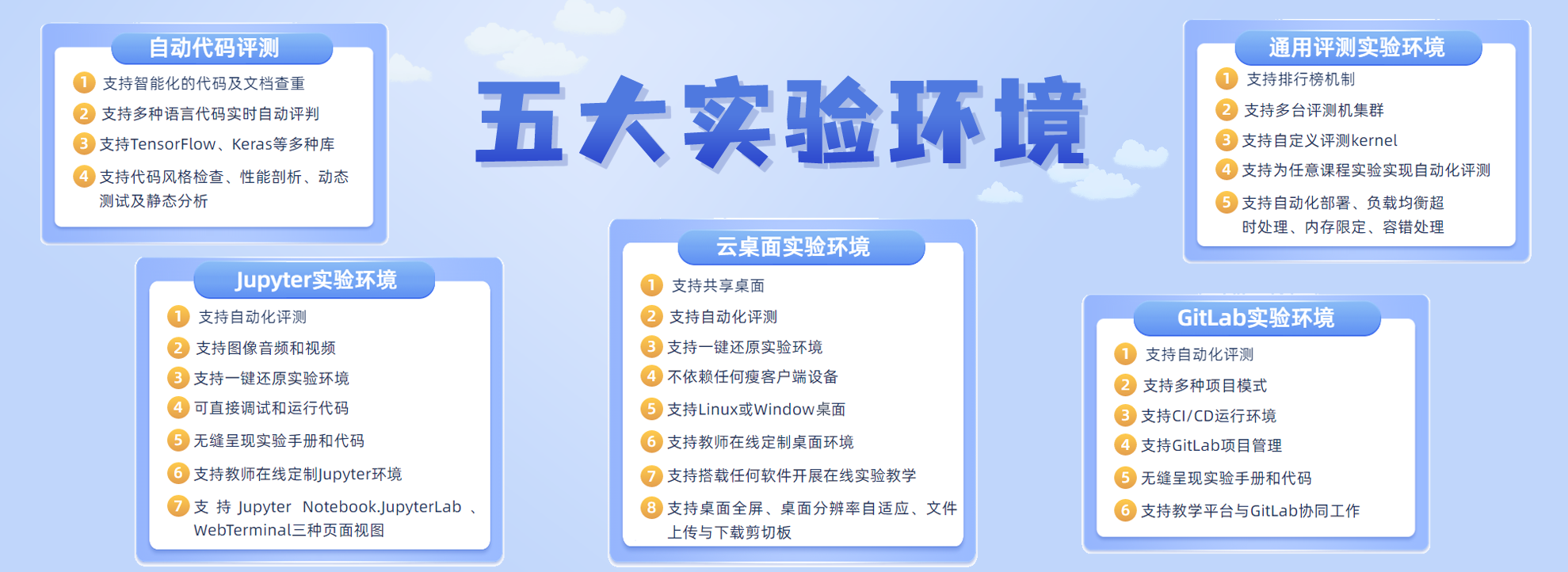

远程桌面 + Jupyter笔记环境 + 通用评测框架 + Web集成评测框架 覆盖所有在线实验与自动评测场景

在线虚拟桌面实验环境

- 随时随地动手练习

-

B/S架构的虚拟桌面实验系统,无需配置环境直接动手练习,极佳的使用体验。

- 快速部署和归档

-

采用虚拟机的实验平台可以实现快速部署和归档,使得实验资源规模可以根据选课学生数量调整,实验后能够长期保存学生实验过程资料。

- 实验过程追踪记录

-

基于CG平台内置的日志追踪系统,细粒度追踪学生实验环节的过程数据,包括:实验进度、实验投入时间、代码行、程序性能、正确率、实验分布时间、提交次数等信息。

- 轻松衔接现有服务器设备

-

支持任何虚拟化技术,可以充分利用学校现有的计算中心(云计算中心)物理设备,为学校打造计算机实验在线机房。

支持高并发和分布式部署,是目前对资源需求较低的在线实验平台,一台服务器能够支撑300人同时在线。 详情

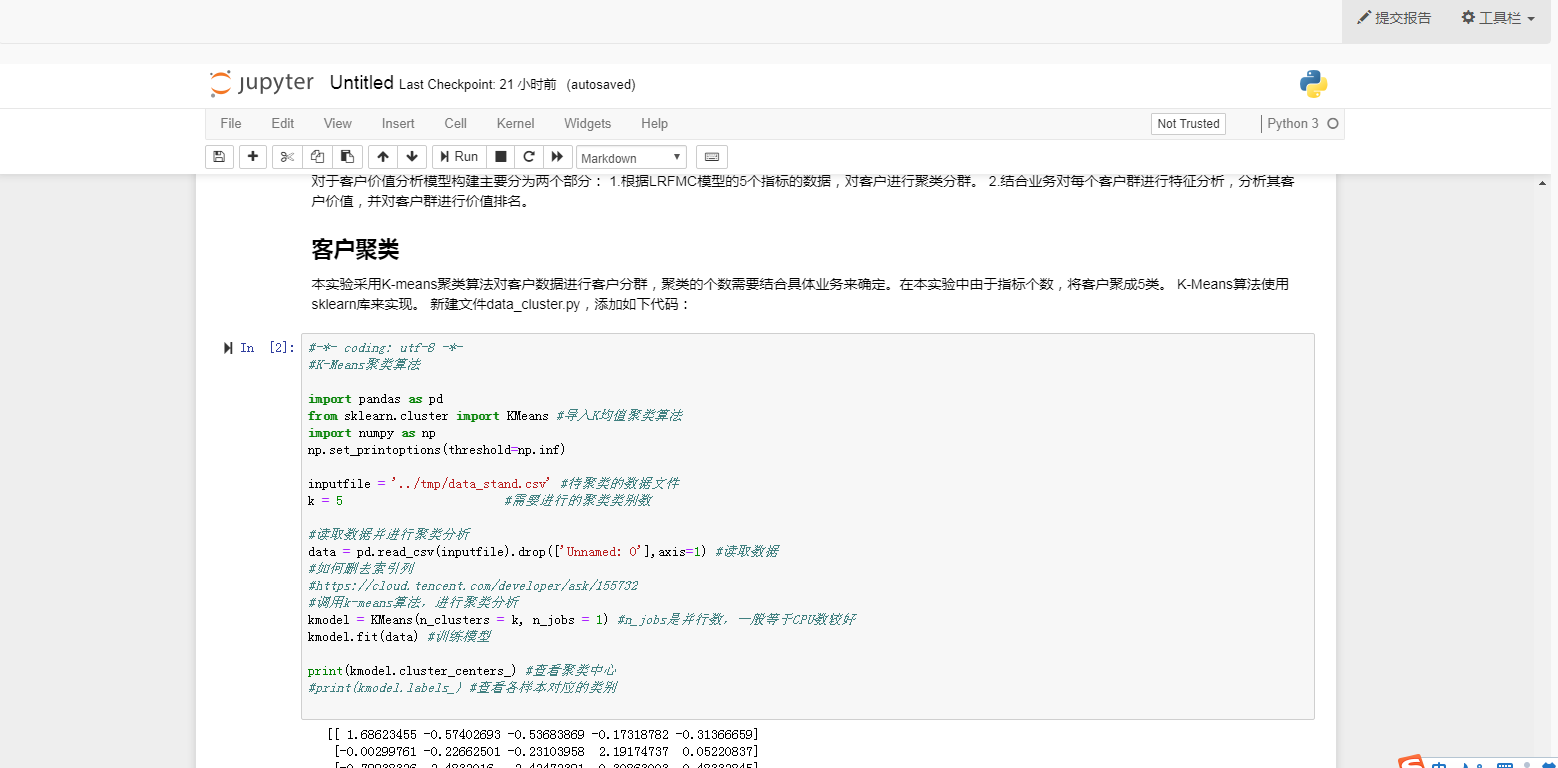

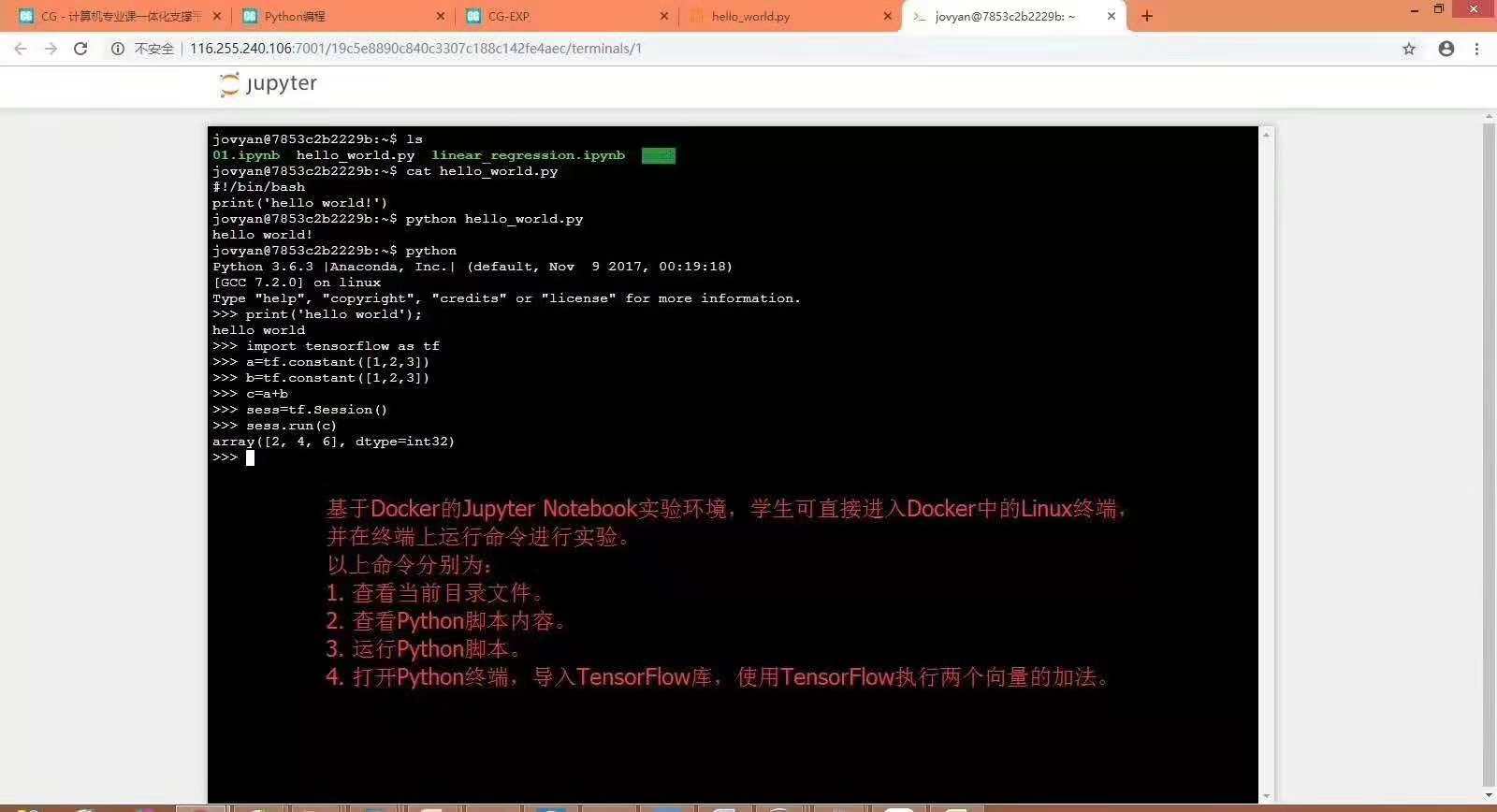

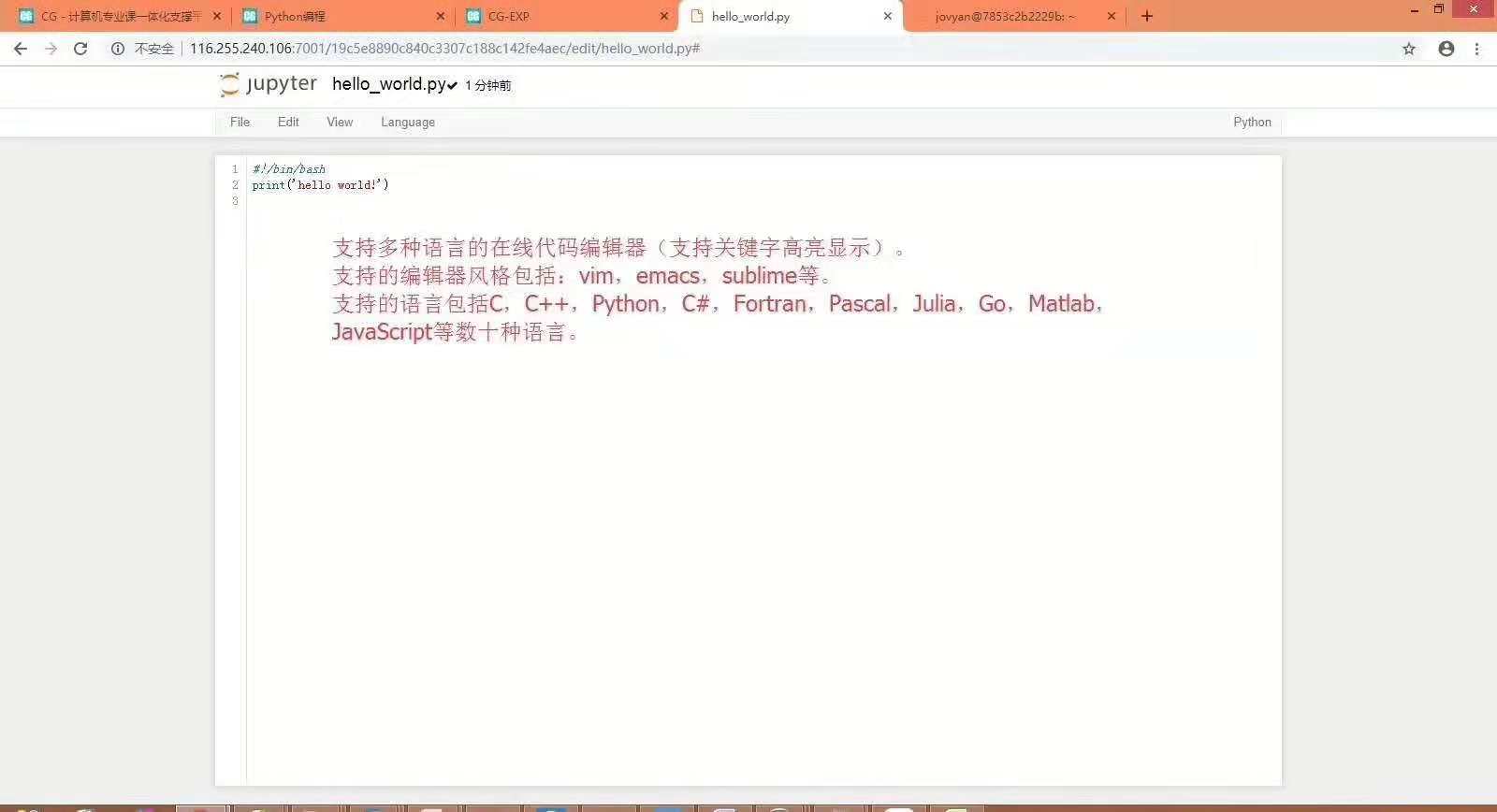

Jupyter笔记实验环境

使用Jupyter撰写实验报告,简化交互式计算与数据分析类实验。实验文档与执行代码收归一处,极好的用户体验。

- 所见即所得

-

无缝呈现手册和代码,学生可直接调试和运行代码,并可直接查看程序的实时运行结果。

- 可开展丰富的实验类型

-

支持图片、图像、图形、音频、视频、动画、游戏等多媒体资源,可开展图像识别、语音识别、视频目标跟踪、智能游戏等领域的实验。支持LaTeX语法、Matlab编程,可开展数学基础实验。支持HTML5、JavaScript,可制作精美的实验报告模板和交互式实验指导手册。

- 便捷的实验资料编辑

-

教师可直接编辑每个实验的实验手册和实验代码,实验代码以Cell的形式编排,可通过删除Cell、修改Cell的方式,删除代码块或删除代码块中部分代码,引导学生根据实验指导手册重新编写空缺的代码内容,从而掌握相关知识点,达到学习目标和实验目标。

- 实验资源可扩展性

-

可在CG平台上一键上传ipynb标准格式文档,该文档中包含实验指导手册和可直接运行的代码。提供1000+个覆盖Python编程、Python实训、人工智能数学基础、数据分析、数据可视化、机器学习、深度学习、自然语言处理、计算机视觉、语音识别、TensorFlow编程、Keras编程等人工智能知识体系中数十种不同方向的高质量ipynb格式实验资源。每个实验资源均包含实验代码、实验手册及实验数据等内容,部分实验资源包含实验指导视频。

一键导入网上开源的Jupyter笔记资源。

通用评测开发框架

- 更加轻量级

-

相比上述两种实验环境,通用评测环境更加轻量级,服务器资源消耗低,可定制性更强。服务器端只负责评测,开发在线下。 案例:系统能力培养大赛-操作系统赛评测机 案例:系统能力培养大赛-编译系统赛评测机

- 可定制性更强

-

支持教师基于Docker为自己课程开发评测机,教师可在评测机内集成每个实验的支撑材料、评测脚本、测试数据、验证数据。在评测脚本中设计评测指标以及根据各评测指标计算评测得分的加权公式。然后以插件的形式与通用评测框架对接。

- 评测内核开发更简单

-

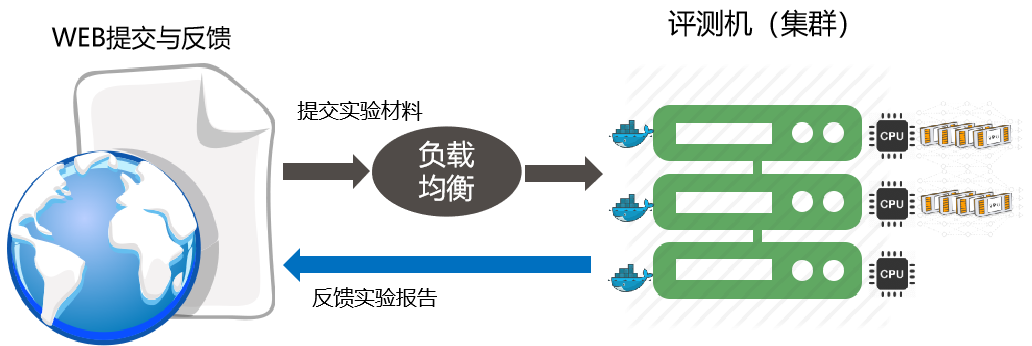

一个高可用的自动评测机制开发难度相当大,需要处理各种异常、安全和性能问题。

通用评测框架解决评测机的分布式部署、负载均衡、评测超时、容错、用户隔离等技术问题。用户只需要专注于评测内核的核心功能开发。开发出来的评测内核与CG平台无缝衔接。

- 高度可扩展

-

高度可扩展的分布式集群管理与任务调度,可以对接真机开发板(例如树莓派),也可以远程调用云计算资源。

- 融合GitLab

-

融合GitLab协同开发与自动评测,量化团队成员贡献,开发过程可视化。

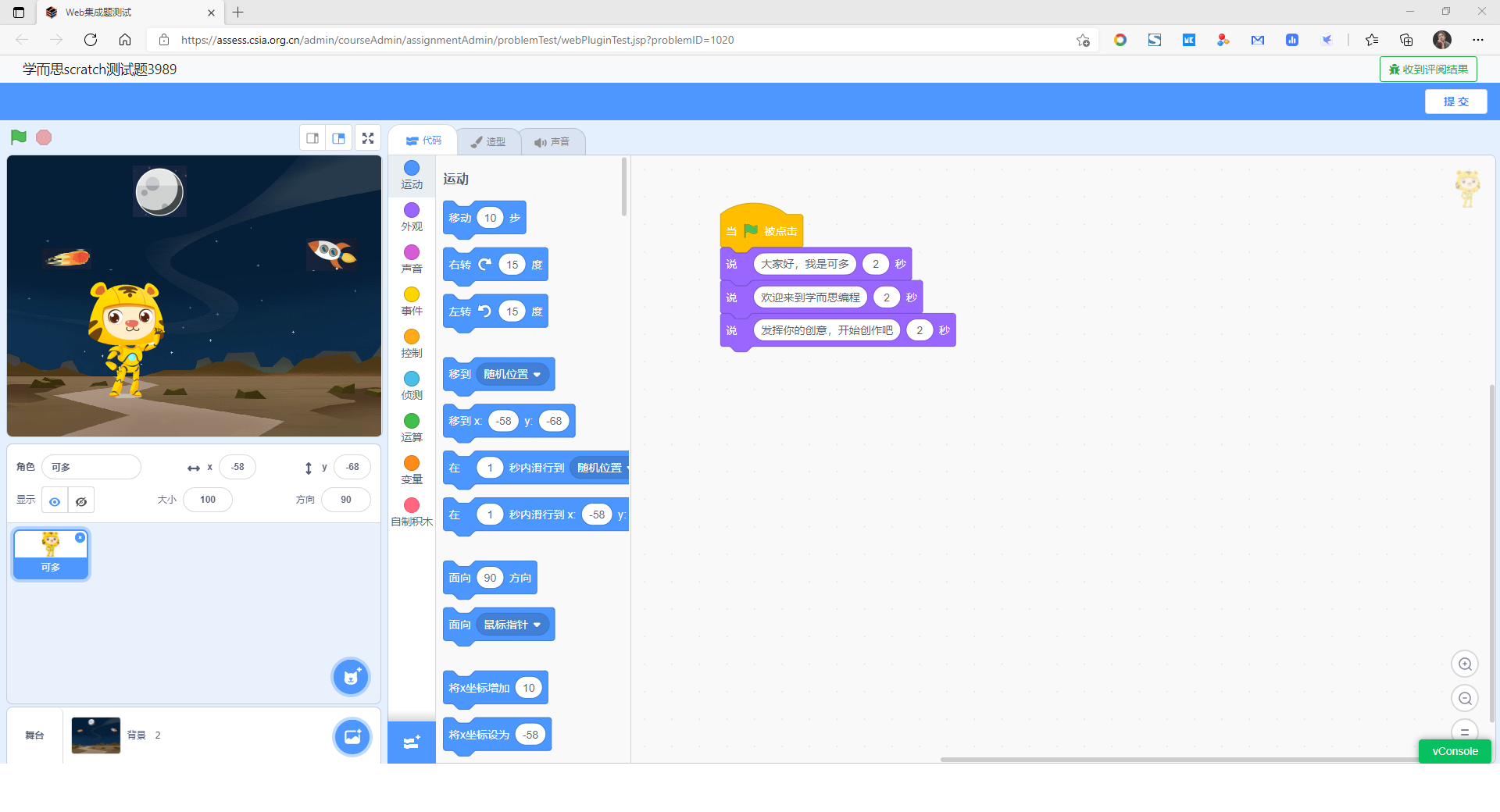

Web集成评测开发框架

一个插件式的开发框架,可以将基于Web开发的第三方系统轻松集成到希冀平台。

相比通用评测框架,Web集成题是一种更加松耦合的集成方式。 被集成的系统只需要开发一些核心基础功能,集成之后就可以共享希冀平台的账号管理、作业、考试、实验等丰富的教学管理功能。

如果待集成的系统已经实现了自动评测,那么通过前端协议,可以轻松将自动评测结果同步到希冀平台。 如左图与学而思少儿编程的集成效果。